A razão pela qual a VRR não é uma solução mágica para corrigir o mau desempenho

Muda as regras do jogo, mas tem os seus limites.

Tudo começou em 2013 com a chegada do Nvidia G-Sync - a primeira forma de tecnologia de ecrã com taxa de atualização variável (VRR). Em vez de tentar sincronizar, ou não sincronizar, a saída da GPU com o ecrã, o hardware anfitrião assumiu o controlo - dando início a uma nova atualização do ecrã quando a GPU estava pronta com um novo grame. A trepidação do V-sync não se verificava e o ruído do ecrã desaparecia (de um modo geral!). Seguir-se-iam o FreeSync e o HDMI VRR, mas essencialmente todos faziam a mesma coisa - suavizar os níveis de desempenho variáveis e proporcionar uma experiência de jogo superior. Mas sejamos claros: a VRR não é uma panaceia. Não é a salvação para o mau desempenho dos jogos. Tem os seus limites e é importante compreendê-los e, no processo, obteremos uma melhor compreensão do desempenho em geral - e porque é que a taxa de fotogramas não é assim tão importante em comparação com outras métricas mais granulares.

Vamos falar sobre os conceitos básicos de VRR. Os ecrãs têm uma taxa de atualização nativa - seja ela de 60 Hz, 120 Hz, 165 Hz ou outra qualquer. Sem a VRR, as opções são limitadas para uma reprodução suave e consistente. Em primeiro lugar, há a ideia de fazer corresponder a taxa de fotogramas do jogo à taxa de atualização do ecrã. Cada atualização do ecrã dá origem a um novo fotograma. O exemplo mais popular disto é o conceito de “60 fotogramas por segundo bloqueados”, em que é gerado um novo fotograma a cada 16,7 ms para corresponder à taxa de atualização de um ecrã de 60 Hz - algo verdadeiramente complicado de conseguir nas consolas, maximizando as suas capacidades.

Em segundo lugar, pode pedir ao seu hardware que ofereça um divisor limpo da taxa de atualização - o exemplo clássico é um jogo de 30 fps a correr num ecrã de 60 Hz. Neste caso, cada atualização recebe um novo fotograma do hardware de origem. Há problemas com isto, como o efeito fantasma, por exemplo, mas este é o compromisso clássico para manter a consistência quando não é possível fazer corresponder a taxa de atualização.

Por fim, existe outra opção menos desejável: ignorar completamente a taxa de atualização do ecrã e enviar o máximo de fotogramas possível, desligando o v-sync. Como os novos fotogramas são entregues enquanto o ecrã está em processo de atualização, obtém-se o screen-tearing - imagens parciais apresentadas em qualquer atualização do ecrã.

A taxa de atualização variável (VRR) resolve todos estes problemas, uma vez que o ecrã cede o controlo da sua taxa de atualização à GPU. Quando um novo fotograma termina de ser processado na GPU, desencadeia uma atualização no monitor. Partindo do princípio de que o tempo necessário para calcular o fotograma tem uma duração semelhante à do último, é possível correr a taxas de fotogramas arbitrárias e a perceção do utilizador é de um jogo suave, consistente e sem falhas, sem estar preso a qualquer objetivo de desempenho específico.

Eu digo “jogos sem lágrimas” - mas há limitações e advertências. Todos os ecrãs têm uma gama de VRR: 48Hz a 60Hz ou 48Hz a 120Hz são exemplos comuns. Se o desempenho do jogo estiver acima ou abaixo do intervalo, as coisas tornam-se um pouco complicadas. Se o desempenho do jogo exceder o limite superior, o ruído do ecrã regressa - por isso, a ativação do v-sync nesta altura limita as taxas de fotogramas ao limite superior do ecrã. Se um jogo descer abaixo dos limites inferiores, o LFC (ou compensação de baixa taxa de fotogramas) entra em ação, duplicando, triplicando (ou mais) o fotograma existente para manter a taxa de atualização dentro da janela VRR.

Se o LFC não for suportado - como se vê no VRR de 60 Hz ao nível do sistema na PlayStation 5 - o v-sync regressa, assim como a trepidação, o que não é nada bom. E mesmo que o LFC esteja a funcionar, poderá notar fantasmas a baixas taxas de fotogramas devido à mesma imagem projetada em várias atualizações de ecrã. Outros problemas? Alguns ecrãs apresentam cintilação quando se deslocam rapidamente através de taxas de atualização variáveis. Em última análise, o VRR funciona melhor quando o desempenho é limitado para se manter abaixo dos limites superiores da gama VRR, com a otimização do jogo a garantir que o LFC é um método de último recurso.

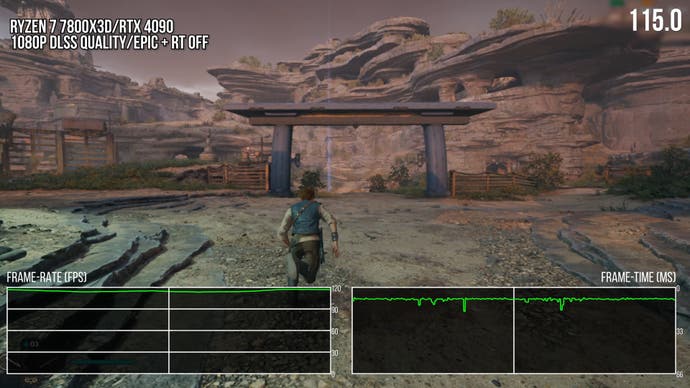

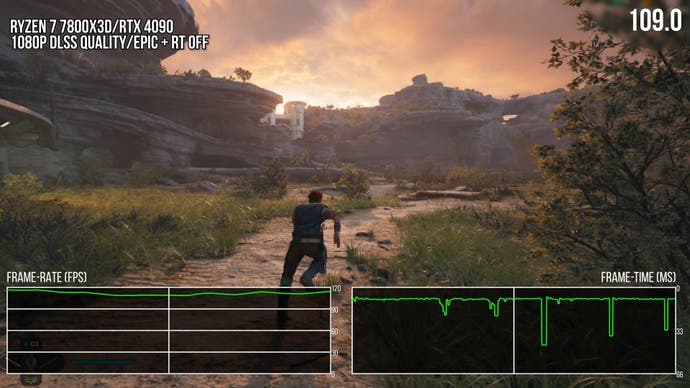

E, mesmo assim, poderá ter problemas porque os conceitos de taxa de fotogramas e taxa de atualização são termos abrangentes que não conseguem abranger muito bem a variabilidade granular do desempenho dos jogos. Coloquemos as coisas desta forma - em teoria, um jogo de 30 fps fornece um novo fotograma a cada 33,3 ms para uma jogabilidade consistente. No entanto, 29 fotogramas a 16,7 ms seguidos de uma enorme falha de 518 ms continuam a ser 30 fps - mas apresentam-se como 60 fps com bolsas contínuas de falhas. Talvez este seja um exemplo exagerado, mas considere o seguinte: se a janela VRR de um ecrã for de 48 Hz a 60 Hz, o VRR só funciona com fotogramas apresentados numa janela de 20,8 ms a 16,7 ms. Na verdade, isso é bastante apertado - e basta dizer que é muito, muito fácil que um stutter transversal ou um stutter de compilação de shader persista por mais de 20,8ms. Muito mais tempo. Nesses cenários, o VRR não pode proporcionar um desempenho bom, suave e consistente. O VRR não pode “consertar” o tipo de gagueira flagrante de que falamos com frequência nos artigos e vídeos da Digital Foundry.

Os ecrãs com janelas de taxa de atualização variável de 48Hz a 60Hz dominaram durante os primeiros dias da tecnologia VRR, mas hoje em dia estamos a 120Hz e mais, até 240Hz e mais. E embora o desempenho da GPU e até da CPU possa fornecer o tipo de força bruta para fornecer taxas de fotogramas tão elevadas, isso só serve para tornar essas enormes falhas ainda mais percetíveis: quanto maior for o nível de desempenho, mais percetível é a falha. É frequente vermos gagueiras na ordem dos 30 ms ou mais. Se corrermos a 120 Hz, estamos a 8,3 ms. A 240 Hz, são 4,17 ms por fotograma. Não se pode deixar de notar estes fotogramas mais longos.

A gagueira pode também manifestar-se de formas menos problemáticas - mas ainda assim percetíveis. Se estiver a correr bem numa janela de 200-240 fps, isso representa uma variação de cerca de 0,8 ms por fotograma. 160-240fps? Isso corresponde a uma variação de 2,1 ms. Apesar do que parece ser um grande abismo na taxa de fotogramas, o VRR ainda pode funcionar bem. No entanto, as variações podem aumentar e chegar a um ponto em que são percetíveis, mesmo que se mantenha dentro da taxa de atualização variável do ecrã. É especialmente percetível se estiver constantemente a alternar entre tempos de fotogramas, uma vez que se apresenta de forma não consistente e gaguejante. Isto pode acontecer com erros de animação, ou se a CPU estiver no máximo - muitas vezes uma das principais causas de gaguez.

Falo de vários exemplos no vídeo incorporado, mas o ponto principal é que é por isso que discordo da ideia de que o VRR pode “corrigir o desempenho de um jogo”. Tem limites. Se um jogo tiver uma taxa de fotogramas que não seja muito variável e tempos de fotogramas muito consistentes e que só mudem gradualmente, a RV fará com que pareça mais suave do que seria com uma taxa de atualização fixa. Um grande exemplo disso é o Dragon's Dogma 2 com o seu último patch, em que os tempos de fotogramas das consolas são geralmente consistentes e a baixa variabilidade da taxa de fotogramas mantém o aspeto suave com a VRR, contra uma experiência insatisfatória num ecrã sem VRR.

No entanto, a VRR não pode corrigir um jogo que tenha problemas com os tempos de fotogramas ou oscilações dramáticas na taxa de fotogramas consoante a cena. Estou a pensar em Star Wars Jedi: Survivor e em vários jogos UE5, bem como no remake de Dead Space para PC. A utilidade do VRR diminui drasticamente neste caso, uma vez que a tecnologia não consegue suavizar efeitos de gaguez relativamente grandes.

O que significa tudo isto? Para mim, isto significa que a VRR não é uma solução mágica. Não podemos desculpar os problemas de um jogo agora que os ecrãs RV estão a tornar-se cada vez mais comuns. A RV não pode consertar um jogo. No entanto, a VRR continua a ser uma tecnologia crucial, na medida em que já não é necessário perseguir obstinadamente um objetivo de desempenho fixo para um jogo consistente - o que, por sua vez, diminui radicalmente a importância da taxa de fotogramas como métrica. A grande maioria dos ecrãs de PC inclui a tecnologia VRR, pelo que diria que a consistência do tempo de fotogramas e as descrições subjetivas da persistência da imagem são muito mais importantes quando se trata de caraterizar o desempenho dos jogos. O desafio está em estabelecer métricas que sejam facilmente compreensíveis por um público que há décadas aceita os FPS como a medida de desempenho por defeito - mas isto é suficientemente importante para dedicarmos tempo e esforço consideráveis a acertar, e a mudança tem de acontecer, mais cedo ou mais tarde.